OpenAIの万能モデルGPT-4oがリアルタイムでインタラクションし、会場を震撼させています。SFの時代が到来しました。

元のタイトル:《 OpenAIが世界を変える:GPT-4oが完全無料、リアルタイム音声ビデオインタラクションが全場を驚かせ、直接SF時代に突入》

著者:機械の心

出典:TechFlow深潮

すごい衝撃です!

各社のテクノロジー企業が大規模モデルのマルチモーダル能力を追い求め、テキストの要約や画像編集機能をスマートフォンに組み込んでいる中、遥かに先を行くOpenAIが直接大技を繰り出しました。発表された製品は、自社のCEOであるオートマンも驚嘆するほどで、「まるで映画のようだ」と言わせました。

5月14日の午前、OpenAIは初の「春の新製品発表会」で新世代のフラッグシップ生成モデルGPT-4o、デスクトップアプリを発表し、一連の新機能を披露しました。今回は、技術が製品の形態を覆し、OpenAIが行動で全世界のテクノロジー企業に教訓を与えました。

今日の司会者はOpenAIの最高技術責任者Mira Muratiで、彼女は主に3つのことを話すと述べました:

第一に、今後OpenAIが製品を作る際は無料を優先し、より多くの人が利用できるようにすること。

第二に、OpenAIは今回デスクトップ版のプログラムと更新されたUIを発表し、使いやすく、より自然になったこと。

第三に、GPT-4の後に新しいバージョンの大規模モデルが登場し、その名前はGPT-4oです。GPT-4oの特別な点は、非常に自然なインタラクション方式で、すべての人にGPT-4レベルの知能を提供することです。これには無料ユーザーも含まれます。

ChatGPTのこの更新以降、大規模モデルはテキスト、音声、画像の任意の組み合わせを入力として受け取り、リアルタイムでテキスト、音声、画像の任意の組み合わせを出力することができます ------ これこそが未来のインタラクション方式です。

最近、ChatGPTは登録なしで使用できるようになり、今日はデスクトッププログラムも追加されました。OpenAIの目標は、人々がいつでもどこでも無感覚に使用できるようにし、ChatGPTをあなたのワークフローに統合することです。このAIは今や生産性そのものです。

GPT-4oは未来の人間と機械のインタラクションの新しい大規模モデルで、テキスト、音声、画像の3つのモダリティを理解し、反応が非常に速く、感情も持ち、人間らしさも備えています。

現場では、OpenAIのエンジニアがiPhoneを取り出し、新モデルのいくつかの主要な能力をデモしました。最も重要なのはリアルタイムの音声対話で、Mark Chenは「初めてのライブ発表会で少し緊張しています」と言いました。ChatGPTは「深呼吸してみてはどうですか」と答えました。

「はい、深呼吸します。」

ChatGPTはすぐに「それはダメです、息が大きすぎます」と返答しました。

もし以前にSiriのような音声アシスタントを使ったことがあれば、ここで明らかな違いがわかります。まず、AIの話をいつでも中断でき、最後まで待つ必要がありません。次に、待つ必要がなく、モデルの反応が非常に速く、人間の応答よりも早いです。第三に、モデルは人間の感情を十分に理解し、自身もさまざまな感情を表現できます。

次は視覚能力です。別のエンジニアが紙に書いた方程式を使い、ChatGPTに直接答えを出させるのではなく、ステップバイステップでどうするかを説明させました。どうやら、問題を解く手助けをする能力が非常に高いようです。

ChatGPTは「数学に悩んでいるとき、私はあなたのそばにいます」と言いました。

次にGPT-4oのコード能力を試しました。いくつかのコードを使い、デスクトップ版のChatGPTと音声で対話し、コードが何のために使われているのか、特定の関数が何をしているのかを説明させました。ChatGPTは流暢に答えました。

出力されたコードの結果は温度曲線グラフで、ChatGPTはそのグラフに関するすべての質問に一言で応じました。

最も暑い月は何月か、Y軸は摂氏か華氏か、すべて答えることができました。

OpenAIはまた、X/Twitter上でユーザーがリアルタイムで提起したいくつかの質問にも応じました。例えば、リアルタイム音声翻訳で、スマートフォンを翻訳機として使い、スペイン語と英語を行き来して翻訳することができます。

さらに、誰かが「ChatGPTはあなたの表情を認識できますか?」と尋ねました。

どうやら、GPT-4oはリアルタイムでのビデオ理解ができるようです。

次に、OpenAIが今日発表した核爆弾について詳しく見ていきましょう。

オールマイティモデル GPT-4o

まず紹介するのはGPT-4oで、oはOmnimodel(オールマイティモデル)を意味します。

初めて、OpenAIは1つのモデルにすべてのモダリティを統合し、大規模モデルの実用性を大幅に向上させました。

OpenAIのCTO Muri Muratiは、GPT-4oは「GPT-4レベル」の知能を提供しますが、GPT-4の基盤の上にテキスト、視覚、音声の能力を改善したと述べ、今後数週間で「段階的」に同社の製品に導入されるとしています。

「GPT-4oの理由は音声、テキスト、視覚を横断しています」とMuri Muratiは言いました。「私たちはこれらのモデルがますます複雑になっていることを知っていますが、インタラクション体験がより自然でシンプルになることを望んでいます。ユーザーインターフェースに気を取られることなく、GPTとの協力に集中できるようにしたいのです。」

GPT-4oは英語のテキストとコードにおいてGPT-4 Turboと同等の性能を持ちますが、非英語のテキストにおいては性能が大幅に向上し、APIの速度も50%向上しました。既存のモデルと比較して、GPT-4oは視覚と音声理解において特に優れています。

音声入力に対して最速で232ミリ秒で応答し、平均応答時間は320ミリ秒で、人間と同等です。GPT-4oが発表される前に、ChatGPTの音声対話能力を体験したユーザーは、ChatGPTの平均遅延が2.8秒(GPT-3.5)と5.4秒(GPT-4)であることを実感できました。

この音声応答モードは、3つの独立したモデルからなるパイプラインで構成されています:1つのシンプルなモデルが音声をテキストに転写し、GPT-3.5またはGPT-4がテキストを受け取って出力し、3つ目のシンプルなモデルがそのテキストを音声に戻します。しかし、OpenAIはこの方法ではGPT-4が大量の情報を失うことを発見しました。例えば、モデルはトーン、複数の話者、背景ノイズを直接観察できず、笑い声、歌、感情を表現することもできませんでした。

しかし、GPT-4oでは、OpenAIはテキスト、視覚、音声をエンドツーエンドで訓練した新しいモデルを開発しました。これは、すべての入力と出力が同じ神経ネットワークによって処理されることを意味します。

「技術的な観点から、OpenAIは音声を一次モダリティとして直接マッピングし、ビデオをリアルタイムでトランスフォーマーに送信する方法を見つけました。これにはトークン化とアーキテクチャに関する新しい研究が必要ですが、全体的にはデータとシステムの最適化の問題です(ほとんどのことがそうです)。」とNVIDIAの科学者Jim Fanはコメントしました。

GPT-4oはテキスト、音声、ビデオを横断してリアルタイム推論を行うことができ、より自然な人間と機械のインタラクション(さらには人 - 機械 - 機械のインタラクション)への重要なステップを踏み出しました。

OpenAIの社長Greg Brockmanもオンラインで「整活」し、2つのGPT-4oがリアルタイムで対話するだけでなく、即興で曲を作成させました。メロディは少し「感動的」でしたが、歌詞には部屋の装飾スタイル、人物の服装の特徴、そしてその間に起こった小さなエピソードが含まれていました。

さらに、GPT-4oは画像の理解と生成において、既存のモデルよりもはるかに優れた能力を持ち、以前は不可能だった多くのタスクが「容易に」実行できるようになりました。

例えば、OpenAIのロゴをコースターに印刷する手助けをさせることができます:

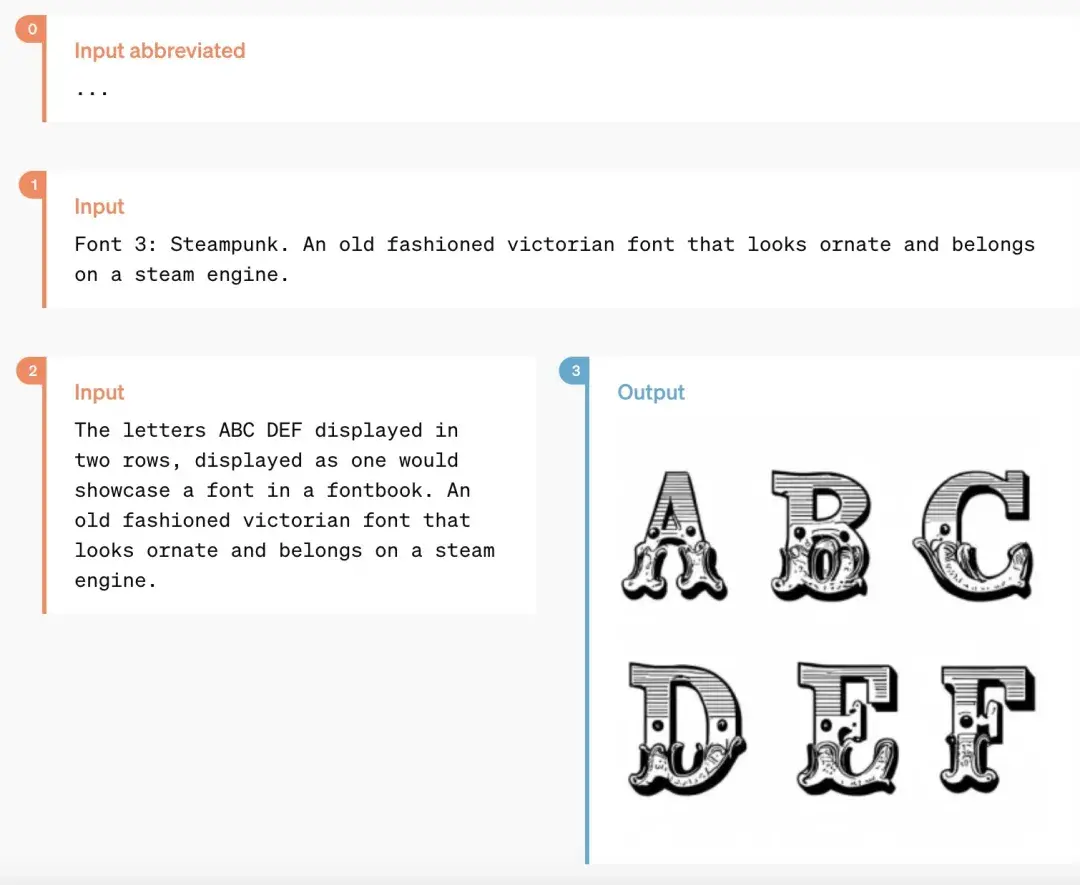

この期間の技術的な攻防を経て、OpenAIはChatGPTがフォントを生成する問題を完璧に解決したようです。

同時に、GPT-4oは3D視覚コンテンツ生成の能力も持ち、6つの生成された画像から3D再構築を行うことができます:

これは詩で、GPT-4oはそれを手書きスタイルでレイアウトすることができます:

より複雑なレイアウトスタイルも可能です:

GPT-4oと協力することで、数段のテキストを入力するだけで、一連の漫画の分割を得ることができます:

以下のような遊び方は、多くのデザイナーを驚かせることでしょう:

これは2枚の生活写真から進化したスタイライズされたポスターです:

また、「テキストをアート文字に変換する」といったニッチな機能もあります:

GPT-4oの性能評価結果

OpenAIの技術チームのメンバーはXで、以前LMSYS Chatbot Arenaで広く議論を呼んだ神秘的なモデル「im-also-a-good-gpt2-chatbot」がGPT-4oの一つのバージョンであると述べました。

比較的難しいプロンプトセットにおいて ------ 特にコーディングに関して:GPT-4oはOpenAIの以前の最良モデルに比べて、性能向上が特に顕著です。

具体的には、複数のベンチマークテストにおいて、GPT-4oはテキスト、推論、コーディングの知能においてGPT-4 Turboレベルの性能を実現し、同時に多言語、音声、視覚機能で新たな高みを達成しました。

推論の向上:GPT-4oは5-shot MMLU(常識問題)で87.2%の新記録を達成しました。(注:Llama3 400bはまだ訓練中です)

音声ASR性能:GPT-4oはWhisper-v3に比べてすべての言語の音声認識性能を大幅に向上させ、特に資源が乏しい言語において顕著です。

GPT-4oは音声翻訳において新たなSOTAレベルを達成し、MLSベンチマークテストではWhisper-v3を上回りました。

M3Examベンチマークテストは多言語評価基準でもあり、視覚評価基準でもあり、複数の国/地域からの標準化されたテストの選択肢を含み、グラフィックやチャートも含まれています。すべての言語ベンチマークテストにおいて、GPT-4oはGPT-4よりも強力です。

今後、モデルの能力向上により、より自然でリアルタイムの音声対話が実現され、リアルタイムビデオを通じてChatGPTと対話できるようになります。例えば、ユーザーはChatGPTに現場のスポーツイベントを見せ、そのルールを説明させることができます。

ChatGPTユーザーは無料でより多くの高度な機能を得られる

毎週1億人以上がChatGPTを使用しており、OpenAIはGPT-4oのテキストと画像機能が今日からChatGPTで無料で提供され、Plusユーザーには最大5倍のメッセージ上限が提供されると述べています。

今、ChatGPTを開くと、GPT-4oがすでに使用可能であることがわかります。

GPT-4oを使用する際、ChatGPTの無料ユーザーは次の機能にアクセスできます:GPT-4レベルの知能を体験すること;ユーザーはモデルとネットワークから応答を得ることができます。

さらに、無料ユーザーには以下の選択肢もあります ------

データを分析し、グラフを作成する:

撮影した写真と対話する:

ファイルをアップロードして要約、執筆、分析の支援を受ける:

GPTやGPTアプリストアを発見し、使用する:

そして、メモリ機能を使用してより役立つ体験を作り出すことができます。

ただし、使用状況やニーズに応じて、無料ユーザーがGPT-4oから送信できるメッセージの数には制限があります。制限に達すると、ChatGPTは自動的にGPT-3.5に切り替わり、ユーザーは対話を続けることができます。

さらに、OpenAIは今後数週間以内にChatGPT Plusで新しいバージョンの音声モードGPT-4o alphaを導入し、APIを通じて信頼できるパートナーに対してGPT-4oの新しい音声およびビデオ機能を提供します。

もちろん、モデルのテストと反復を重ねる中で、GPT-4oにはすべてのモダリティにおいていくつかの限界があります。これらの不完全な点について、OpenAIはGPT-4oの改善に努めていると述べています。

想像できるのは、GPT-4oの音声モードのオープン化がさまざまな新しいリスクをもたらすことです。安全性の問題に関して、GPT-4oはトレーニングデータのフィルタリングやトレーニング後のモデル行動の微調整などの技術を通じて、クロスモーダル設計に安全性を組み込んでいます。OpenAIはまた、音声出力の保護のために新しい安全システムを構築しました。

新しいデスクトップアプリがユーザーのワークフローを簡素化

無料および有料ユーザー向けに、OpenAIはmacOS用の新しいChatGPTデスクトップアプリを発表しました。シンプルなキーボードショートカット(Option + Space)を使用することで、ユーザーはすぐにChatGPTに質問できます。また、ユーザーはアプリ内でスクリーンショットを直接取得し、議論することもできます。

現在、ユーザーはコンピュータから直接ChatGPTと音声対話を行うことができ、GPT-4oの音声およびビデオ機能は今後提供されます。デスクトップアプリの右下隅にあるヘッドフォンアイコンをクリックすることで音声対話を開始できます。

本日より、OpenAIはPlusユーザーにmacOSアプリを提供し、今後数週間でより広く提供される予定です。また、今年の後半にはWindows版も発表される予定です。

オートマン:あなたたちはオープンソース、私たちは無料

発表が終了した後、OpenAIのCEOサム・オートマンは久しぶりにブログ記事を発表し、GPT-4oの開発時の心の旅を紹介しました:

「今日の発表では、2つのことを強調したいと思います。

まず、私たちの使命の重要な部分は、強力な人工知能ツールを人々に無料(または手頃な価格で)提供することです。私は非常に誇りに思っています。私たちはChatGPTで世界最高のモデルを無料で提供し、広告やその類のものはありません。

OpenAIを設立したとき、私たちの最初の構想は、人工知能を創造し、それを利用して世界にさまざまな利益をもたらすことでした。今、状況は変わり、私たちは人工知能を創造し、他の人々がそれを使ってさまざまな驚くべきものを創造し、私たち全員がその恩恵を受けることになるようです。

もちろん、私たちは企業であり、多くの有料のものを発明するでしょう。これにより、数十億人に無料で素晴らしい人工知能サービスを提供できることを願っています。

次に、新しい音声およびビデオモードは、私が使用した中で最も優れた計算インタラクションインターフェースです。映画の中の人工知能のように感じます。私はそれが本当に存在することにまだ少し驚いています。人間レベルの応答時間と表現能力を達成することは大きな飛躍です。

初期のChatGPTは言語インターフェースの可能性を示唆しましたが、この新しいもの(GPT-4oバージョン)は本質的に異なる感覚を与えます ------ それは速く、知的で、面白く、自然で、助けを提供します。

私にとって、コンピュータとのインタラクションは決して自然なことではありませんでした。事実です。そして、私たちが(オプションの)パーソナライズ、個人情報へのアクセス、AIに人間の行動を代行させる能力を追加するとき、私は本当に興奮する未来を見ています。私たちはコンピュータを使って以前よりも多くのことを行うことができるのです。

最後に、この目標を達成するためにチームが尽力してくれたことに心から感謝します!」

ちなみに、先週オートマンはインタビューで、ユニバーサルベーシックインカムは実現が難しいが、「ユニバーサルベーシックコンピュート」を実現できると述べました。将来的には、すべての人がGPTの計算能力を無料で得られ、使用、転売、寄付することができるようになります。

「この考えは、AIがますます進化し、私たちの生活のあらゆる側面に組み込まれるにつれて、GPT-7のような大規模言語モデルユニットを持つことが金銭よりも価値があるかもしれないということです。あなたは生産性の一部を持っているのです。」とオートマンは説明しました。

GPT-4oの発表は、OpenAIがこの方向に向けて努力していることの始まりかもしれません。

そう、これはまだ始まりに過ぎません。

最後に、今日OpenAIのブログで紹介された「5月13日の発表を推測する」という動画は、ほぼ完全にGoogleの明日のI/O大会の予告編と一致しており、これは間違いなくGoogleに対する直接的な挑戦です。今日のOpenAIの発表を見た後、Googleは大きなプレッシャーを感じたのでしょうか?